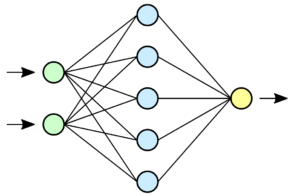

Künstliche Intelligenz (KI) ist gar nicht überirdisch. Z.B. ein „Chat“ mit ChatGPT beginnt, indem man ein Thema auswählt, z.B. „Putin und der Ukraine-Krieg“ oder „Aristoteles und die Tugenden“. Wenn wir Alfred Schütz in seinem Buch „Das Problem der Relevanz“ (S. 56) folgen, dann ist die Situation so: „In einem unstrukturierten Feld wird etwas zu einem Problem gemacht und dabei gliedert sich das Feld in Thema und Horizont“. Das Thema setzen wir, den Horizont aber liefert uns ChatGPT, und dieser Horizont ist gewaltig. Wir befinden uns in der Welt der „Big Data“ und der „Schnellen Rechner“, die uns das Mooresche Gesetz vorhergesagt hat. Ohne diese Voraussetzungen gäbe es keine moderne KI, die weit über das bekannte „mechanical reasoning“ („Mechanische Schließen“ oder mechanische Logik) hinausgeht. Wir haben es heute mit der Subsymbolischen KI zu tun, die als Weiterentwicklung der Symbolischen KI angesehen werden kann. Im Zentrum der Subsymbolischen KI stehen die Neuronalen Netze, eine Nachbildung biologischer Nervenzellen. Ein einfaches künstliches Neuron ist die MCulloch-Pitts-Zelle, die schon 1943 eingeführt wurde.

Abb. 1 Ein Neuronales Netz mit Input, Zwischenschicht und Output nach Wikipedia

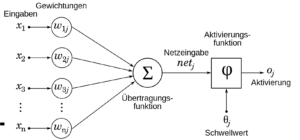

Ein einzelnes Neuron nach McCulloch-Pitts sieht so aus, wie in Abb. 2 gezeigt wird.

Abb. 2 Ein Neuron nach Wikipedia

Auf ein Neuron z.B. in der Mittellage treffen verschiedene Kanten mit den Wert xi . Eine Kante zwischen zwei Neuronen ai uns aj wird gewichtet mit wij. In einer Übertragungsfunktion werden die xi gewichtet aufsummiert und an eine Aktivierung übertragen. Die Aktivierung ist nichts anderes als ein klassischer ECA- Trigger der Informatik mit den Komponenten E (Event), Condition (C), Action (A). Wird die Bedingung erfüllt, dann erfolgt die Aktivierung. Man sagt auch, das Neuron wird gefeuert.

Der Hit von ChatGPT ist die Einführung subsymbolischer Funktionen.

Bleiben wir zunächst im Symbolischen. Wir erfahren in der Schule, was eine Funktion ist. Der Lehrer schrieb an die Tafel: y= f(x), mit x als eine unabhängige und y als eine abhängige Variable. Wenn wir Gottlob Frege (1848- 1925) folgen, müssen wir bei f(x) streng zwischen der Funktion f ( . ) und seinem x unterscheiden. Frege spricht vom Argument x. In seiner berühmten Schrift „ Funktion, Begriff, Bedeutung“ nennt Frege f ( . ) eine ungesättigte Funktion. Er gibt als Beispiel 2 * x3 + x an und macht etwas Ungesättigtes daraus: 2 * ( . )3 + ( . ).

( . ) nennt er Leerstelle, die nach einem Ausfüllen verlangt.

Der Fregesche Funktionsbegriff gilt aber nicht nur für numerische Werte. Auch allgemeine Behauptungssätze lassen sich so erfassen.

Beispiel: „Caesar eroberte Gallien“

wird zerlegt in „Caesar“ und „eroberte Gallien“.

Der zweite Teil „(.) eroberte Gallien“ ist ungesättigt, eine ungesättigte Funktion, und „Caesar“ ist ein Argument.

Die Pointe nun ist, dass Neuronale Netze als allgemein, ungesättigte Funktionen aufgefasst werden können. Wir geben in ChatGPT ein Thema ein, z.B. „Putin und der Ukraine-Krieg“, sättigen also die ungesättigte Funktion eines Neuronalen Netzes, und herauskommt ein passabler Text, wie wir ihn z.B. in Tageszeitungen lesen können. Der Text ist aber frisch generiert und nicht von irgendwo kopiert. Es ist ein Unikat.

Wie kann das sein? Wo hat ChatGPT das her? Antwort: Das ist ihm antrainiert worden. Archive von Tageszeitungen, Wikipedia, Patentschriften, Fachartikelsammlungen etc. sind zum Training eingefüttert worden, damit ChatGPT lernt, wie man im Deutschen redet. Es wird ein Redemodell des Deutschen angefertigt, kein Sprachmodell, wie fälschlicherweise in der Literatur zu lesen ist. Seit dem großen Linguisten Ferdinand de Saussure aus Genf (1857-1913) wissen wir, dass wir Sprache und Rede unterscheiden müssen. De Saussure nannte auf Französisch eine Sprache „langue“ und eine Rede dann „parole“. Englisch heißt das „language“ und „speech“. In der ChatGPT-Literatur spricht man von einem „Large language model“ (LLM). Es müsste korrekt im Sinne de Saussures „Large speech model“ (LSM) heißen. Denn es steht eine ungeheure empirische Redevielfalt zur Debatte und keine Sprachstruktur, um die sich der linguistische Strukturalist de Saussure gekümmert hat. Da wir beliebig viele Sätze produzieren können, atmen wir den Hauch des Unendlichen und nennen das „Big Data“. Wir unterscheiden seit Aristoteles das potentielle und das aktual Unendliche . Gemeint ist hier das potentiell Unendliche, da wir unendlich viele Sätze produzieren könnten, es aber nicht tun, weil wir nur endlich lange leben. Das aktual Unendliche ist eine Schimäre, ein Trugbild des Menschen. „Big Data“ ist „big“, aber endlich. Das ist tröstlich.

Zu den Aspekten „Problemlösen“, „Thema“ und „Horizont“

Generative KI produziert ohne Sinn und Verstand „Big Data“ (Extension). Nur der Mensch kann die Begriffe (Intension) zum Verstehen der Datenmengen (character strings) hinzu liefern. Und diese kann er natürlich zur Schwierigkeitsbestimmung des Problemlösens, wie der Psychologe Dietrich Dörner in seinem Buch „Problemlösen als Informationsverarbeitung“ (2. Auflage, 1979), in ein Schema einordnen: „Mittel bekannt oder unbekannt“ sowie „Ziele bekannt oder unbekannt“.

Wenn beide (Mittel und Ziele) unbekannt sind, spricht man von Gedankenblitzen, plötzlichen Einfällen oder mit Kant von synthetischen Urteilen a priori. Generative KI kann hier den Menschen heute beim Erzielen sinnvoller Gedankenblitze unterstützen. Sie fasst dabei aber selbst keine Gedanken, sie produziert bzw. generiert (subsymbolisch) lediglich Wortfolgen oder character strings.

Für das Gedanken fassen war in der Sprachlogik und Mathematik Gottlob Frege 1848-1925) das Genie. Sind Freges Aufsätze „Der Gedanke“ (1918), „Die Verneinung“ (1919) und „Gedankengefüge“ (1923), die den Menschen und nicht die Technik betreffen, denn heute schon „Quatsch mit Soße“?

Wenn nicht die generative KI, so doch die zukünftige interdisziplinäre neuronale KI muss sich dieser Frage stellen. Wie lässt sich der Zusammenhang zwischen Gehirnforschung, KI und Mensch-basierter Sprachlogik (Gottlob Frege) wissenschaftlich erforschen und begründen?

Dies wäre ein lohnenswertes für das Überleben der Menschheit wichtiges, globales Forschungsprogramm, dass die Mensch-Technik-Interaktion theoretisch wie praktisch gewaltig voranbringen könnte. 2025 jährt sich Gottlob Freges Todestag zum 100. Mal.

Sehr geehrter Herr Wedekind,

als damals die KI aufkam, habe ich auf ihr Anraten ein sehr kritisches Buch von Hubert Dreyfus, „What Computers Can’t Do“ gelesen. Das war in den 80igern als der erste KI-Hype anfing. Die dortigen Kernaussagen stimmen immer noch.

In der Hard-Science-Fiktion Buchreihe „Singularity“ von William Hertling wird im ersten Band „Advogardo Cooperation: The Singularity is closer than it appears“ sehr elegant das Kernproblem der KI übersprungen. Wann und wie erkennt eine KI sich selbst, bekommt also einen Zugang zum „ich“ und entwickelt daraus eine „Lebens- und Überlebensstrategie“.

Biologische Systeme tragen in sich den Drang zu Leben in sich, hierzu kritisch Richard Dawkins, The Selfish Gene, ist in diesem Zusammenhang auch lesenswert.

Unsere jetzigen KI sind genau das, was das engliche Wort Artifical Intelligence bedeutet. „Intelligence“ das Sammeln und Auswerten von Information (nicht zu übersetzen mit dem deutschen Wort Intelligenz, siehe in der Abkürzung „CIA“ wofür dort Intelligence steht.) Ähnliches gilt für „artifical“ dies bedeutet „künstlich hergestellt“ entsprechend einem Kunststoff.

Das deutsche „KI“ ist eine metaphorologische Irreführung, die AI des Englischen ist näher am Sachverhalt.

Für mich die entscheidende Frage bleibt – kann eine KI je ein eigenes Bewusstsein entwickeln, sonst bleibt es ein System das Daten sammelt und auswertet, Muster erkennt und diese interpretiert. Es bleibt jedoch ein Spiel mit Symbolen, dies aber sehr geschickt, schneller als der Mensch, mit einem nahezu unendlichen Gedächtnis, dem auch Ziele vorgeben werden können.

Bekäme die KI ein Bewusstsein, könnte sie sich selbstbestimmt Ziele setzen, dann wären wir wieder bei „Singularity“.

Das waren jetzt ein paar Gedanken aus Harbord Village.

Gruß

Dieter Steinbauer